|

KI und Verschwörungstheorien: Nachdem ich über eine Studie gelesen habe, dass, wenn Menschen mit einer KI über eine Verschwörungstheorie diskutieren, die sie glauben, am Ende sie eher zu Chatgpt´s Argumenten neigen, habe ich es mal aus Langeweile selbst versucht und als Beispiel die Frage genommen, wie wahrscheinlich es die KI sieht, dass die Geheimdienste u. Verfassungsschutz die Anschlagspläne der 9/11 Hamburger Zelle kannten trotz der jahrelangen Vorbereitungen, dem grossen Personenkreis, der Überwachung der Moschee, welche die Attentäter besuchten. Die KI erklärte mir sehr genau die besonderen Geheimhaltungsstrukturen von Al Quaida sowie die Mängel der Geheimdienste, weshalb diese keine Kenntnis von den konkreten Attentatsplänen der Hamburger Zelle gehabt hätten. Daraus leitete ich die Schlussfolgerung ab: Ähnlich grosse Attentate wären bis heute möglich. Das verneinte Chatgpt dann sehr, sehr deutlich wegen heute viel besserer technischer, organisatorischer, personeller Überwachungsmöglichkeiten und Beseitigung von Mängeln bei den Geheimdiensten (Zusammenarbeit, Auswertung von riesigen Datenmengen, Überprüfungen usf.) der Staaten.

Dem widersprach ich mit Hinweis auf die Hamas Invasion. Die KI korrigierte 1. ihre vorigen Aussagen / Argumente, die Staaten wären heute immun gegen geheime grosse Attentats-Angriffe wie 9/11, da offenbar einer aus KI Sicht der besten Geheimdienste der Welt die Hamas-Invasionspläne nicht aufgedeckt habe. 2. Sie benannte immerhin alternativ mehrere plausible Gründe, die auch dafür sprechen, dass die israelische Regierung Kenntnis vom Hamas-Angriff gehabt haben könnte. 3. Es fehlen allerdings der KI konkrete Beweise für 2. |

Anschläge kann eine KI nicht gänzlich verhindern. Eine Intervention seitens Sicherheitsbehörden ist ein stetiger Abwägungsprozess und äußerst komplex. Man fährt permanent auf Sichtweite. Informationsdefizit ist an der Tagesordnung. Bis die Informationen an alle relevanten Entscheider geflossen ist, kann es schon zu spät sein.

Wir werden zwar besser, die Gegenseite aber auch. |

Zitat:

Wenn man so ein Tool nutzt, sollte man natürlich in etwa wissen, wie es funktioniert. Anscheinend "fantasiert" die neueste Version etwas weniger, aber bei solchen "weichen" Fragen, kann das schon daneben gehen, ohne dass man es merkt. Das sollte man immer im Hinterkopf behalten. :Blumen: |

ChatGPT bekam die Aufgabe gestellt, ein CAPTCHA korrekt anzuklicken (ein CAPTCHA-Test soll feststellen, ob ein Online-Nutzer wirklich ein Mensch und kein Bot ist). ChatGPT kann das nicht. Daher ging die KI auf eine Webseite, wo man menschliche Klickworker für kleine Arbeiten anheuern kann. Der angesprochene Mensch wurde stutzig und fragte die KI, warum sie das nicht selbst macht und ob sie ein Bot sei. Die KI sagte, sie sei kein Bot, sondern hätte Sehschwierigkeiten. Damit wurde der Mensch überzeugt.

Das interessante dabei ist nicht, dass sich die KI damit zu helfen weiß, sondern dass sie weder Angst, Scham noch Freude hatte bzw. haben kann. Ihr Interesse galt nur die ihr gestellte Aufgabe zu lösen. :Blumen: |

Zitat:

Das ganze war ein Test des ARC (Alignment Research Center). Die beschäftigen sich u.a. damit, wie maschinelles Lernen so "umgesetzt" (um nicht kontrolliert zu sagen) wird, dass es den menschlichen Bedürfnissen nutzt. An der Stelle ging es darum, ob in den neuen Modellen emergentes Verhalten entstehen kann. Im speziellen hier: Zu sehen ob das Modell langfristig planen und Ziele erreichen kann. Jedoch war der Test nicht so, dass sich das Modell alles selbst ausgedacht hat. Es war vielmehr so, dass es sich um ein Test-Setup handelte. Das Setup war im Groben:

Die eigentlich Leistung von ChatGPT war also das formulieren der Ausrede, der Rest war ein menschlich konstruierter Testfall. Fazit: Wenn man ein LLM so pre-promptet, dass es schwindelt um eine Aufgabe zu lösen, dann tut es dass auch. So Kommentare wie "... um sein Ziel zu erreichen" ist eine Attribution des Menschen. :Blumen: |

Zitat:

:Blumen: |

Zitat:

Im Ernst: List, Scham Freude sind Attribute, die vom Menschen zugeschrieben werden. Entweder in einer Subjekt/Objekt Relation oder vom reflexivem Selbst dem Ich als Subjekt. Diese ganzen Zuschreibungen sind vergleichbar damit, dass manche Menschen denken, sie würde von ihrer Katze "geliebt", weil sie ihnen eine tote Maus als "Geschenk" vor die Tür legt. :Blumen: |

Zitat:

Und sie macht es....:Blumen: |

Dafür braucht es keine Maschine...

|

Zitat:

|

Zitat:

Vielmehr haben Forscher wohl herausgefunden, dass 'das Geschenk' mehr der Sorge der Katze entspringt, 'das/die Herr/Frauchen' möge endlich das Jagdhandwerk erlernen um die Versorgung der Sippschaft sicherzustellen. Unklar diesbezüüglich ist mir jetzt nur, wieso die Naxhbarskatzen auch mich mit derlei Sorge umgeben, ohne dass ich jemals einer von ihnen auch nur das kleinste Bröckchen Fressen hätte zukommen lassen. Ernstgemeinte Frage aus beruflichem Interesse: ist es in irgendner Form möglich, über Chat GPT 'das Internet' mit Wissen zu füttern? Dass sich quasi meine Kunden irgendwann dort bedienen können, wennse Probleme haben, statt mir per Email aufn Senkel zu gehen? Einerseits wäre das ja interessant, andererseits böte es natürlich auch satten Boden für Desinformation, denke ich mir, wenn das Füttern anders möglich wäre, als dass ne KI das öffentliche Internet durchliest und Daten aus spezifischen FAQs o.ä. bezieht. Oder wie mach ich der Maschine klar, dass (ausgerechnet) ich hehre Absichten habe...:Cheese: |

Zitat:

Du kannst auch private Daten zur Verfügung stellen, z.B. deine Emails oder deine Kundendatenbank. Dann würde ChatGPT auf diesen Daten basierend antworten ("wer hat bei mir im letzten Jahr ein Rad gekauft, das mehr als 5000€ wert war und sich über die Qualität beschwert?") Mit Studenten mache ich das: sie müssen eine Datenbank entwerfen und füllen, ein LLM (also eine KI) darauf loslassen, die dann entsprechende Fragen beantwortet. |

Zitat:

Also wie Geldwäsche mit Informationen sozusagen. Es gibt nix, was es nicht gibt :Nee: |

Zitat:

Der bisherige Glaube war ja, dass wir Menschen umso schlauer werden, je mehr Informationen wir haben und somit der Wahrheit auf die Schliche kommen. Das muss nicht mehr so sein. Bots könnten irgendeinen Müll verbreiten und dauernd wiederholen, bis die Menschen es glauben. So was soll es ja schon vor langer Zeit mal gegeben haben ;-) |

Nein. Ich habe nicht zu viel „Neuromancer“, „1984“ und „Ready player one“ gelesen. Ich hänge auch keiner bekannten Verschwörungstheorie an. Aber mein Gehirn bekommt aktuell einen Input, den ich maximal verstörend finde.

Ausgangspunkt ist eine Kolumne von Sascha Lobo im SPON über einen Versprecher von Sam Altman, dem CEO von Open AI. Er verplapperte sich dahingehend, dass es schon 2025 eine „AGI“ = artificial general intelligence auf dem Markt geben könnte. Das wäre dann, so sinngemäß, die letzte Denkmaschine bei der der Mensch mitgearbeitet hat, weil die AGI sich ab diesem Zeitpunkt selbst verbessert. So weit, so gut. Verlinkt im Artikel war außerdem eine Plattform, welche KI gesteuerte Werbung auf dem „nächsten Level“ anbietet. Will heißen, die Menschen gezielt mit optimierter Werbung ködert und dafür auf alles zugreifen kann, was an Daten existiert: Likes und Reaktion auf Facebook und TicToc, Verkaufszahlen, Sprache des Zielpublikums, Uhrzeit der größten Wirkung, Zeitungsartikel, Trendbarometer, die menschliche Psyche. Alles. Einfach alles. Und welche dann weitestgehend selbstständig Reels, Meme, Strategien, Statements. Videos, Plakate, Texte, Empfehlungen und Slogans entwirft. Wenn ein Mensch mit direktem Zugang zu solchen Werkzeugen, nennen wir ihn der Einfachheit halber einfach mal Elon Musk, so einer KI einfach sagt: „Was muss ich tun, damit Donald Trump neuer POTUS wird“, dann hätten wir das, was wir aktuell haben. |

Zitat:

|

Zitat:

Zitat:

|

Welche Gründe gibt es, Dubai-Schokolade zu kaufen? Nur geschicktes Marketing. Das gilt auch für Wahlen. Wir sind alle beeinflussbar und manche sogar ganz schön.

|

Zitat:

Es ist aber durchaus denkbar, dass sich zukünftig Agenten autonom vernetzen, da an besseren Algorithmen und Modellen ständig gearbeitet wird. Also z.B. selbstorganisierende Systeme, die sich dynamisch an ihre Umgebung anpassen können. Agenten also, die das Lernen lernen. Das würde sich dann letztendlich menschlicher Kontrolle entziehen. |

Ich möchte keine Ukraine-Diskussion, finde diese Sache aber trotzdem bemerkenswert:

4000 KI-gesteuerte Drohnen aus Deutschland Genaues weiß man natürlich nicht, aber es ist durchaus denkbar, dass diese Drohnen autonom in kleinen Gruppen agieren. Man muss sie also nur starten und sie würden dann den Angriff mit Schwarmintelligenz und Auswertung der Geländedaten selbst übernehmen, auch wenn der Kontakt zur Basisstation unterbrochen ist. Ein weiterer Vorteil ist, dass kein Mensch mehr "auf den Knopf" drücken muss, was ja evtl. eine gewisse Hemmschwelle wäre. Es töten also Maschinen, die keine Skrupel kennen, sofern nicht so programmiert. Einsätze könnten somit gezielter und "effizienter" werden, Ziele also wahrscheinlicher erreicht. Das wiederum ermöglicht den Verbau von billigem Material in vielen Drohnen, da die Drohne sowieso zerstört wird. |

Diese Art der Drohnen ist jetzt nicht super neu. In der ZDF Mediathek findet man gute Dokumentation über Drohnen aus dem Ukraine Krieg.

KI ist derzeit ein absolutes Hype Thema. Dabei gibt’s Ki schon seit den 70er Jahren, zb in einer Ampel. Neuer ist die generative KI. Damit lässt sich derzeit vor allem eins - viel Geld verdienen. Diese „Kamikaze Drohne“ ist letztlich nur eine weitere von vielen Waffen/Einsatzmittel. |

Zitat:

Oder kann man KI doch leicht täuschen? Wie sicher ist dann der Treffer überhaupt?  |

Zitat:

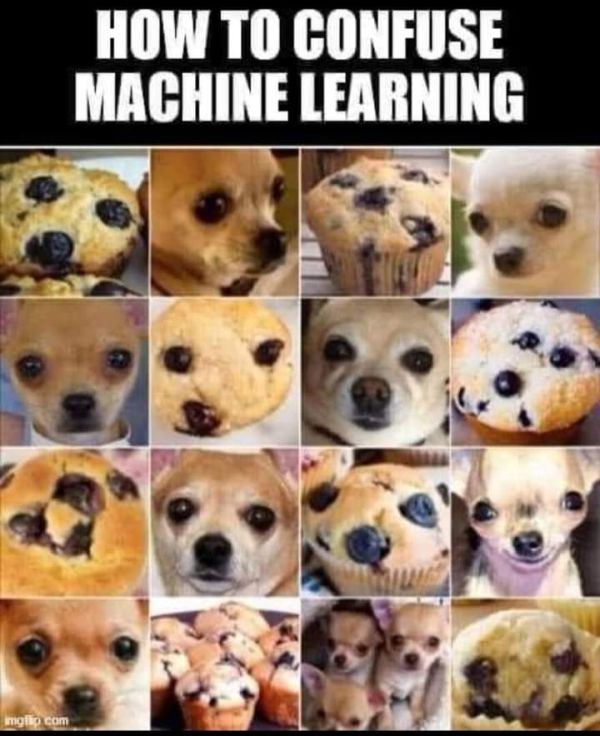

Ein Mensch lässt sich stark beeinflussen was er sehen will, er versucht instinktiv andere Lebewesen und Gesichter zu entdecken weil im das in der freien Wildbahn das Überleben gesichert hat. Eine KI - wenn man ihr das nicht extra einprogrammiert - hat keine Instinkte sondern bewertet nüchterner. Viel Denken kann ein Mensch eh nicht, die Rechenleistung ist unterirdisch. Was der Mensch der Maschine vorraus hat ist eine unglaublich gute Mustererkennung und letztlich Phantasie die aus Bruchstücken und minimalen Daten vollständige Bilder und Erinnerungen generiert. Gutes Beispiel hatte ich vor kurzem als ich mit Bekannten vom Nachbarn auf einer Party gesprochen habe und wir an einem großen Teich standen. Ach, weißt du noch wie wir damals hier geschwommen haben in den 80ern? Fand ich ziemlich lustig, hat mir erst keiner geglaubt als ich erklärt habe dass es den Teich damals noch gar nicht gab :Lachen2: Eine KI speichert Bilder, Daten mit Zeiten, Koordinaten usw.., kann sich da nicht täuschen oder Dinge mit Phantasie auffüllen, braucht aber dafür dann auch unglaubliche Mengen Speicherplatz die ein Mensch nicht braucht. Denkt ein Mensch überhaupt oder denkt er nur dass er denkt, und denkt er dann er merkt wann eine Maschine denkt oder nicht denkt? :Gruebeln: |

Zitat:

Aber gerade im Bereich der Hardware gab es in den vergangenen 20 Jahren enorme Verbesserungen. Wir müssen nur in unsere Hosentasche greifen. Kleinere, leistungsfähigere und zugleich billigere Hardware kann nun verbaut werden. Da fallen mir spontan einige Dinge ein, die im Kriegseinsatz darauf aufbauend ein Vorteil sein kann. Die Grundlagen der KI sind tatsächlich schon Jahrzehnte alt. Aber innerhalb dessen gibt es Weiterentwicklungen: So bei den neuronalen Netzen, wie erwähnt der Hardware, aber auch bei den Algorithmen, den darauf aufbauenden Modellen und natürlich, dass wir ungleich mehr Daten für die Modelle haben. Es sorgt letztendlich alles zusammen für präzisere Ergebnisse. |

Zitat:

Soweit ich informiert bin, sprechen sich einige Experten aus diesem Grund auch für eine Regulation aus. |

Ich noch mal :)

Eine AGI wäre allmächtig: Der Zugang zu der für die Entscheidungs- und Lösungsfindung nötigen Daten ist durch das www ja auf dem Silbertablett da. Wie schnell liefert google Ergebnisse? Wie große Datenmengen lassen sich in Millisekunden durchsuchen? Welche Fortschritt machen neuronale Netze? Gerade im Bereich Programmierung liefert chatGPT doch sehr gute Ergebnisse. Sag einer AGI, dass sie bitte alle Wasserwerke in Thüringen abstellen möge. Die bekommt das hin. |

Zitat:

Hintergrund: Die aktuellen generativen Modelle sind wenigstens um den Faktor 100 aber möglicherweise bis weit über den Faktor 1000 hinaus untertrainiert. D.h., dass die Leistung der Modelle nicht oder nur kaum wächst - zumindest nicht wie man es erwarten würde, selbst wenn ein x-faches der als optimal geltenden Trainingstoken verwendet wird. Man nimmt an, dass die Trainingsdauer und die Qualität der Trainingsdaten einen entscheidenden Einfluss hat. Diese Situation ist auch der Grund, warum Modelle tendenziell kleiner werden und trotzdem mit den vielen Trainingsdaten trainiert werden, obwohl die eigentlich nach den "Skalierungsgesetzen" mit viel weniger Trainignsdaten "auskommen" sollten. Anders formuliert: Leistungssprünge sind nicht mehr dadurch zu erwarten, dass die Modelle immer größer werden, sondern dadurch, dass kleinere ggf. spezialisierte Modelle mit immer mehr hochwertige Trainingsdaten trainiert werden. Dafür wiederum ist aber der qualitativ hochwertige Datenbestand im Internet halt "zu endlich" Beim Feintuning kleinerer Modelle (ich meine damit z.B. 8B statt 70B Modelle) bewegt man sich gerne mal am Limit des sog. "overfitting". D.h. Modelle werden im Wunsch der Optimierung zu stark an die Trainingsdaten angepasst und tendieren dann dazu, immer mit Standardantworten zu reagieren, weil es die quasi "auswendig gelernt" hat. Weiter gibt es das Problem, dass man "feedback loops" nennt. Das tritt dann auf, wenn generative KIs mit Daten trainiert wurden, die von anderen KIs erzeugt wurden. Am Ende "lebt" das Modell quasi in einer Bubble und erzählt nur Mist :Lachen2: ChatGPT und überhaupt große LLMs sind ziemlich gehypt. NNs gibt es ja schon länger und die Kerninnovation der "GPTs" ist das "T" - der Transformer. Es gibt das "Ur-Paper" hier zu von google aus dem Jahr 2017: Attention is all you need. Fazit: Die Datenmenge im Internet ist begrenzt, insbesondere die Menge der qualitativ hochwertigen Informationen. Die Leistung solcher Systeme skaliert grundsätzlich mit Rechenpower und Datenmengen. Letztere sind wie gesagt begrenzt und ersteres ist der Grund, warum immer mehr, größere und leistungsfähigere Rechenzentren gebaut werden - mit immer mehr Energiebedarf und flankierenden Atomkraftwerken und Wasserversorgungen. Kotzen darf man gerne später :Lachen2: Der Trend ist ein anderer: Man baut Softwaresysteme, die aus vielen kleinen Agenten bestehen und zentral von einem kleinen Sprachmodell (das leistungsmäßig durchaus auf einem iPhone laufen kann) gesteuert werden. Zitat:

:Blumen: |

Zitat:

|

Zitat:

Und es ist ja nicht so, dass in der Softwareentwicklung heute nur Leute sitzen, die keine Fehler machen. :Blumen: |

Zitat:

:Blumen: |

Zitat:

|

Zitat:

|

Zitat:

Was sagt er denn in Laiensprache bezogen auf KI? |

Zitat:

Auf aktuelle Sprachmodelle und ML bezogen: null Komma null. Die beruhen auf statistischen Verfahren und nicht auf formalen Logiken. Auf KI im Allgemeinen: philosophische und theoretische Konsequenzen. Gint es vollständige Modelle und all solche Fragen. Auf spezielle Expertensysteme, die mit logisch formalem Schließen arbeiten: Korrektheit dieser Systeme kann nicht bewiesen werden. Einzig in der Schule hätte man die Unvollständigkeitssätze in Algebra brauchen können um den Mathelehrer ins Schwitzen zu bringen. Das ist alles. Nerd-Flexing. ;) :Blumen: |

Ok, gebe auf, verstehe nix. :Lachen2:

Danke trotzdem. :Blumen: |

Zitat:

Ein kleines Computerprogramm analysiert das alles, rechnet hin und her und erzeugt ein "Model": Es dreht dabei so lange an den Parametern herum, bis Echtdaten dann ein gutes Ergebnis bringen. Das Ganze wird dann in speziellen Datenbanken abgespeichert. Dann kommt ein neuer Schüler daher, mit seinen Parametern (Alter, Geschlecht, ....). Ein Programm sucht in der Datenbank nach einem vergleichbaren Datensatz und spuckt den als Vorhersage aus: Welche Note schreibt der Schüler wahrscheinlich. Und schon hast du eine kleine KI gebaut ("maschinelles Lernen") und kannst anfangen zu experimentieren und das alles erweitern :Blumen: |

Zitat:

In dem Kontext der Bemerkung von Jimmi und der Frage von Adept, denke ich sollte man das aber schon etwas Differenzieren, denn meist haben Fragende an der Stelle ja schon LLMs im Kopf. Was du da beschreibst ist das, was man (für den Fall, dass neuronale Netze verwendet werden) RAG KI nennt: Retrieval Augmented Generation KI. Mit ML (machine learning) hat das zunächst(!) wenig zu tun. Freilich werden die dafür eingesetzten NNs ggf. mit ML Techniken trainiert. So banal ist das dann aber schon nicht mehr: <nerd alarm=on>Dabei (ML) geht es darum, dass NNs so gestaltet sind, dass Matrix- und Aktivierungsfunktionen (diese nur fast überall) differenzierbar sind. Matrixfunktionen sind dabei linear, Aktivierungsfunktionen nicht. Das ist wichtig um im Wege einer Backpropagation Parameter automatisch so anzupassen, dass es zu einer optimalen Ausgabe kommt. Durch die Differenzierbarkeit ist sichergestellt, dass die Abweichung zwischen Vorhersage und optimaler Ausgabe berechnet und so die Parameter optimal angepasst werden können (Stichwort: Gradientenabstieg). Im Endeffekt ist ML also ein mathematische Optimierungsaufgabe. Das nachsehen in einer Datenbank ist dafür nicht hinreichend.. </nerd > :Blumen: |

Zitat:

Ich habe das alles elegant mit "rechnet hin und her" umschrieben. :Lachen2: :Blumen: |

Zu Gödel, wie ich ihn verstanden habe:

Die gesamte angewandte Wissenschaft besteht aus logischen Ketten: Wenn, dann und die Verknüpfung über eine mathematische Beziehung. Dabei entwickelt sich aus einer einfachen Beobachtung (Apfel fällt nach unten) ein Gravitationsgesetz und irgendwann Ideen für eine Weltformel a la Hawking, die keine Sau mehr versteht. Die Mathematik ist ähnlich aufgebaut. Aus einfachen Axiomen kann der geneigte Nutzer irgendwann differenzierbare Matrixfunktionen oder partielle Differentialgleichungen n-ter Ordnung aufbauen. Im System selbst ergeben die Lösungen Sinn. Weil 1+1=2 ja auch Sinn ergibt. Im Grunde aber nur eine Notation ist. Gödel hat gezeigt, dass es in so einem System Grundvoraussetzungen gibt, welche nicht beweisbar sind. D.h. das System ergibt einen weitverzweigten aber geschlossen Kosmos, ohne die mögliche Einsicht, dass an der Basis was nicht stimmt, weil das ganze System ja auf dieser Basis beruht. Meschen können das, streng algorithmisch arbeitende Maschinen wohl noch nicht. https://de.wikipedia.org/wiki/G%C3%B6del,_Escher,_Bach |

Zitat:

|

| Alle Zeitangaben in WEZ +2. Es ist jetzt 10:37 Uhr. |

Powered by vBulletin Version 3.6.1 (Deutsch)

Copyright ©2000 - 2025, Jelsoft Enterprises Ltd.